循环神经网络TextRNN实现情感短文本分类任务

目录

- 情感短文本分类

- TextRNN的基本原理

- TextRNN在情感短文本分类中的应用

- 总结

情感短文本分类

TextRNN是一种循环神经网络(RNN)结构,特别适用于处理序列数据。它通过将上一个时刻的隐状态与当前时刻的输入进行结合,来预测下一个时刻的输出。

情感短文本分类是指将文本数据划分为具有不同情感极性的类别,其中文本长度通常较短。这是一项有挑战性的自然语言处理任务,因为情感识别需要考虑词汇的情感标记、句子成分和背景信息等多方面因素。在解决该问题时,我们需要选择高效且准确的算法来自动判断文本所代表的情感极性。

TextRNN的基本原理

TextRNN是一种能够对序列数据进行建模的RNN结构,js涵盖了一个或多个循环单元。每次迭代中,TextRNN将上一个时间步的隐藏状态和当前时间步的输入拼接起来,再通过激活函数传递给下一个隐藏状态,直到序列结束。

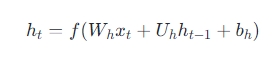

TextRNN的一般公式可表示为:

其中,xtx_txt是第t个时间步的输入,ht−1h_{t-1}ht−1是前一个时间步的隐藏状态,WhW_hWh 和 UhU_hUh 是可训练参数, fff 是激活函数。TextRNN结构通过循环单元构成编程客栈的链式结构来获取序列中的信息。

TextRNN在情感短文本分类中的应用

TextRNN已被广泛应用于情感短文本分类任务。下面我们将介绍如何使用TextRNN实现情感短文本分类,并对其进行详细讲解。

首先,我们需要将每个单词转换为固定大小的特征向量,以便能够输入到神经网络中。为了实现这一点,我们可以使用嵌入层将每个单词映射到固定维度的向量空间。

然后,我们可以使用TextRNN对特征进行建模。可以使用多层循环单元来捕获更深层次的语义信息。在训练过程中,我们需要使用反向传播算法来更新模型参数,并使用交叉熵损失函数来提高模型的正确率。

最后,我们需要将提取到的特征投影到相应的情感标签上。为了实现这一点,我们可以使用全连接层来完成数据的分类,然后输出代表正面、负面或中性情感极性的标签。

下面是一个使用TextRNN模型实现情感短文本分类任务的代码示例:

import numpy as np

from keras.layers import Dense, LSTM, Input, Embedding, Bidirectional

from keras.models import Model

class TextRNN:

def __init__(self, max_len, num_classes, vocab_size, embedding_dim=128, hidden_dim=64):

self.max_len = max_len

self.num_classes = num_classes

self.vocab_size = vocab_size

self.embedding_dim = embedding_dim

self.hidden_dim = hidden_dim

def build_model(self):

inputs = Input(shape=(self.max_len,), dtype='int32')

embed = Embedding(input_dim=self.vocab_size, output_dim=self.embedding_dim, input_length=self.max_len)(inputs)

rnn = Bidirectional(LSTM(units=self.hidden_dim, return_sequences=True))(embed)

rnn = Bidirectional(LSTM(units=self.hidden_dim))(rnn)

outputs = Dense(self.num_classes, activation='softmax')(rnn)

model = Model(inputs=inputs, outputs=outputs)

model.compile(loss='categorical_crossentropy', optimizer='adam', metrics=['accuracy'])

return model

dgmpUZkLUef train(self, X_train, y_train, X_test, y_test,BATch_size = 64, epochs = 10):

model = self.build_model()

model.fit(X_train, y_train, batch_size=batch_size, epochs=epochs, validation_data=(X_test, y_test))

ret编程客栈urn model

# 数据预处理

max_len = 100 # 最大文本长度

vocab_size = 5000 # 词汇表大小

embedding_dim = 128 # 嵌入维度

hidden_dim = 64 # RNN隐藏层维度

# 加载数据并进行预处理

编程客栈from data_loader import DataLoader

data_loader = DataLoader(max_len,max_len,training=False)

X_train, y_train, X_test, y_test, word_index= data_loader.load_data()

vocab_size=len(word_index)

# 进行模型训练

text_rnn = TextRNN(max_len=max_len, num_classes=3, vocab_size=vocab_size,

embedding_dim=embedding_dim, hidden_dim=hidden_dim)

model = text_rnn.train(X_train, y_train, X_test, y_test,batch_size=64,epochs=5)

# 进行预测

y_pred = model.predict(X_test)

y_pred = np.argmax(y_pred, axis=1)

需要注意的是,上述代码使用Keras库实现TextRNN模型。我们构建了一个包含Embedding、LSTM、Bidirectional和Dense层开发者_开发教程等的模型,并在最后一层加入了softmax的激活函数来预测情感分类类别。在训练过程中,我们使用categorical_crossentropy作为损失函数,并使用adam优化器进行参数更新。另外,在完成模型训练后,我们可以对测试数据进行预测并计算出准确率。

总结

本文介绍了如何使用TextRNN实现情感短文本分类任务。TextRNN是一种能够对序列数据进行建模的RNN结构,通过将输入序列依次传递给循环单元来获取序列中的信息。该方法被证明在情感短文本分类任务中表现良好,可以处理较短的文本序列并捕获其语义信息。同时,使用TextRNN还可以轻松地扩展和调整模型架构来获得更好的性能,更多关于TextRNN短文本分类任务的资料请关注我们其它相关文章!

加载中,请稍侯......

加载中,请稍侯......

精彩评论