从入门到精通详解LangChain加载HTML内容的全攻略

目录

- 引言:当大语言模型遇见html

- 一、HTML加载器

- 为什么需要专门的HTML加载器

- 核心加载器对比表

- 二、实战演练:四种加载方式详解

- 1. 基础加载 - BSHTMLLoader

- 2. 保留结构 - UnstructuredHTMLLoader

- 3. 动态网页 - WebBaseLoader

- 4. 批量抓取 - AsyncHtmlLoader

- 三、内部揭秘:HTML加载器如何工作

- 处理流程解析

- 关键技术解析

- 四、避坑指南:HTML加载的七个致命错误

- 五、最佳实践:工业级HTML处理方案

- 完整处理流水线

- 智能内容提取技巧

- 六、面试考点:HTML加载的深度问答

- 七、未来展望:HTML处理的进化方向

- 八、结语:HTML处理的终极艺术

引言:当大语言模型遇见HTML

想象一下,你邀请了一位学识渊博的教授来家里做客,结果他进门后径直走向你的书架——但书架被透明保鲜膜裹得严严实实!这就是大语言模型(LLM)面对HTML内容时的窘境。HTML就像这层保鲜膜,包裹着宝贵的内容,却让LLM无从下口。别担心,LangChain就是你的"HTML开箱刀"!

在这篇全面指南中,我们将深入探索如何用LangChain优雅地处理HTML内容。准备好迎接代码、原理和实用技巧的盛宴吧!

一、HTML加载器

为什么需要专门的HTML加载器

- 标签污染:HTML中60%的内容是标签而非有效文本

- 结构信息:标题、段落等语义结构对理解至关重要

- 动态内容:现代网页大量依赖JavaScript渲染

- 资源分离:css/js文件与内容分离

LangChain提供多种加载器应对这些挑战:

from langchain.document_loaders import (

UnstructuredHTMLLoader,

BSHTMLLoader,

WebBaseLoader,

AsyncHtmlLoader

)

核心加载器对比表

| 加载器 | 优点 | 缺点 | 适用场景 |

|---|---|---|---|

| UnstructuredHTMLLoader | 保留结构信息 | 依赖外部服务 | 复杂文档处理 |

| BSHTMLLoader | 纯python实现 | 功能较基础 | 简单HTML提取 |

| WebBaseLoader | 内置JS渲染 | 需要浏览器 | 动态网页 |

| AsyncHtmlLoader | 异步高效 | 仅获取原始HTML | 批量处理 |

二、实战演练:四种加载方式详解

1. 基础加载 - BSHTMLLoader

适合处理静态HTML文件:

from langchain.document_loaders import BSHTMLLoader

loader = BSHTMLLoader("example.html")

data = loader.load()

print(f"文档内容:{data[0].page_content[:200]}...")

print(f"元数据:{data[0].metadata}")

2. 保留结构 - UnstructuredHTMLLoader

使用Unstructured API保持文档结构:

from langchain.document_loaders import UnstructuredHTMLLoader

# 使用元素模式保留结构

loader = UnstructuredHTMLLoader("blog_post.html", mode="elements")

docs = loader.load()

# 打印检测到的元素类型

for doc in docs:

print(f"元素类型: {doc.metadata['category']}")

print(f"内容: {doc.page_content[:80]}{'...' if len(doc.page_content) > 80 else ''}")

print("-" * 50)

3. 动态网页 - WebBaseLoader

处理需要javascript渲染的页面:

from langchain.document_loaders import WebBaseLoader

loader = WebBaseLoader([

"https://example.com/dynamic-content",

"https://web.with-js.com"

])

loader.requests_per_second = 2 # 礼貌爬取

docs = loader.load()

print(f"加载了{len(docs)}个文档")

4. 批量抓取 - AsyncHtmlLoader

高效处理大量网页:

from langchain.document_loaders 编程客栈import AsyncHtmlLoader

from langchain.document_transformers import Html2TextTransformer

urls = [f"https://news-site.com/page/{i}" for i in range(1, 6)]

loader = AsyncHtmlLoader(urls)

html = loader.load()

# 转换为纯净文本

html2text = Html2TextTransformer()

docs_transformed = html2text.transform_documents(html)

print(f"第一页标题:{docs_transformed[0].page_content.splitlines()[0]}")

三、内部揭秘:HTML加载器如何工作

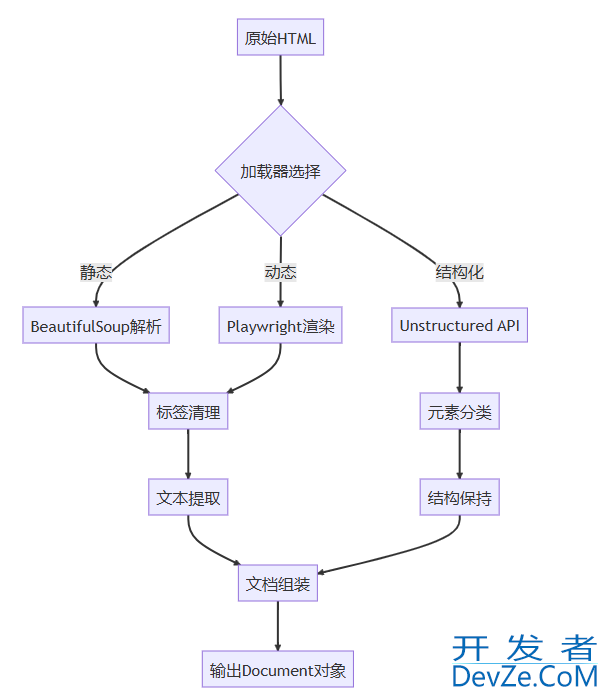

处理流程解析

关键技术解析

DOM树遍历:深度优先搜索算法提取文本节点

内容分类器:基于规则和机器学习识别标题/正文

动态渲染:无头浏览器执行JavaScript

文本规范化:

- 合并相邻文本节点

- 智能空格处理

- Unicode规范化

元数据提取:

<title>标签内容<meta>描述信息- OpenGraph协议数据

四、避坑指南:HTML加载的七个致命错误

忽略编码问题

# 错误做法:默认utf-8

loader = BSHTMLLoader("gbk_page.html")

# 正确做法:指定编码

loader = BSHTMLLoader("gbk_page.html", encoding="gbk")

过度请求被封IP

# 添加延迟和伪装头

loader = WebBaseLoader(

urls,

header_template={

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36",

"Accept-Language": "en-US,en;q=0.9"

},

requests_per_second=2

)

遗漏动态内容

# 确保启用JS渲染

loader = WebBaseLoader("https://react-app.example")

loader.scrapejs = True # 默认已启用

处理登录墙

# 使用会话保持cookies

from requests.sessions import Session

session = Session()

session.post("https://site.com/login", data={"user": "...", "pass": "..."})

loader = WebBaseLoader("https://site.com/protected", session=session)

无限滚动陷阱

# 手动处理滚动

from playwright.sync_api import sync_playwright

with sync_playwright() as p:

browser = p.chromium.launch()

page = browser.new_page()

page.goto("https://infinite-scroll.site")

# 滚动5次

for _ in range(5):

page.evaLuate("window.scrollTo(0, document.body.scrollHeight)")

page.wait_for_timeout(2000) # 等待加载

content = page.content()

loader = BSHTMLLoader.from_string(content)

忽略反爬机制

# 使用代理轮询 proxies = ["http://proxy1:port", "http://proxy2:port"] loader = AsyncHtmlLoader(urls, proxies=proxies, rotate_proxy=True)

内存爆炸

# 分批处理大文件

from langchain.text_splitter import RecursiveCharacterTextSplitter

splitter = RecursiveCharacterTextSplitter(

chunk_size=2000,

chunk_overlap=200

)

docs = loader.load()

chunks = splitter.split_documents(docs)

五、最佳实践:工业级HTML处理方案

完整处理流水线

from langchain.document_loaders import WebBaseLoader

from langchain.document_transformers import Html2TextTransformer

from langchain.text_splitter import RecursiveCharacterTextSplitter

from langchain.embeddings import OpenAIEmbeddings

from langchain.vectorstores import Chroma

def html_processing_pipeline(url):

# 1. 加载

loader = WebBaseLoader(url)

raw_docs = loader.load()

# 2. 转换

html2text = Html2TextTransformer()

cleaned_docs = html2text.transform_documents(raw_docs)

# 3. 分块

splitter = RecursiveCharacterTextSplitter(

chunk_size=1500,

chunk_overlap=200,

separators=["\n\n", "\n", "。", "!", "?"]

)

chunks = splitter.split_documents(cleaned_docs)

# 4. 向量化

embeddings = OpenAIEmbeddings()

vectorstore = Chroma.from_documents(chunks, embeddings)

return vectorstore

# 使用示例

store = html_processing_pipeline("https://example.com")

retriever = store.as_retriever(search_kwargs={"k"python: 3})

智能内容提取技巧

# 使用CSS选择器精准定位

from bs4 import BeautifulSoup

def extract_main_content(html):

soup = BeautifulSoup(html, 'html.parser')

# 策略1:尝试常见内容容器

selectors = [

'article',

'.post-content',

'.article-body',

'main',

'[role="main"]'

]

for selector in selectors:

element = soup.select_one(selector)

if element and len(element.text) > 500:

return element.get_text()

# 策略2:回退到正文密度检测

all_text = soup.get_text()

return all_text # 实际应用中应实现正文密度算法

# 集成到LangChain

class SmartHTMLLoader(BSHTMLLoader):

def load(self):

raw_docs = super().load()

for doc in raw_docs:

doc.page_content = extract_main_content(doc.page_content)

return raw_docs

六、面试考点:HTML加载的深度问答

Q: 如何处理需要登录的网页? A: 需要维护会话状态,典型方案有:

- 使用

requests.Session保持cookies - Playwright的存储状态重用

- 模拟登录后保存身份令牌

Q: 大型HTML文档导致内存溢出怎么办?

A: 采用流式处理:

from langchain.document_loaders import UnstructuredFileIOLoader

with open("large.html", "rb") as f:

loader = UnstructuredFileIOLoader(f, strategy="fast")

for chunk in loader.lazy_load():

process(chunk)

Q: 如何保证网页内容的最新性?

A: 实现缓存策略:

from datetime import timedelta

from langchain.cache import SQLiteCache

loader = WebBaseLoader("https://news.com")

loader.cache = SQLiteCache(

ttl=timedelta(hours=1), # 1小时缓存

db_path=".cache.db"

)

Q: 如何处理多语言HTML内容?

A: 需要语言检测和特殊处理:

from langdetect import detect

docs = loader.load()

for doc in docs:

lang = detect(doc.page_content)

doc.metadata["language"] = lang

if lang == "ja": # 日语需要不同分句

php custom_split_japanese(doc)

七、未来展望:HTML处理的进化方向

AI增强解析

- 使用LLM识别内容区域

- 自动过滤广告/推荐内容

视觉感知处理

# 结合截图理解布局

from playwright.sync_api import sync_playwright

with sync_playwright() as p:

browser = p.chromium.launch()

page = browser.new_page()

page.goto(url)

page.screenshot(path="screenshot.png")

# 使用CV模型分析布局

layout = analyze_layout("screenshot.png")

content = extract_by_coordinates(html, layout)

交互式抓取

# 自动化交互操作www.devze.com

loader = WebBaseLoader("https://dashboard.example")

loader.playwright_actions = [

{"action": "click", "selector": "#load-more"},

{"action": "type", "selector": "#search", "text": "keyword"},

{"action": "wait_for", "selector": ".results"}

]

八、结语:HTML处理的终极艺术

LangChain的HTML加载器就像一位经验丰富的考古学家——他能从HTML的废墟中挖掘出知识的宝藏,拂去标签的尘埃,还原内容的真容。通过本指南,你已经掌握了:

- 四类加载器的精准选择

- 动态内容的完整处理方案

- 工业级处理流水线搭建

- 复杂场景的应对策略

- 面试深度问题的解答思路

记住,优秀的HTML处理不是简单地移除标签,而是理解内容背后的结构和语义。

到此这篇关于从入门到精通详解LangChain加载HTML内容的全攻略的文章就介绍到这了,更多相关LangChain加载HTML内容请搜索编程客栈(www.devze.com)以前的文章或继续浏览下面的相关文章希望大js家以后多多支持编程客栈(www.devze.com)!

加载中,请稍侯......

加载中,请稍侯......

精彩评论