Python进行数据分析的全流程指南

目录

- 一、数据采集:打通数据源的"任督二脉"

- 1. 结构化数据采集

- 2. 网页数据爬取

- 3. API接口调用

- 二、数据清洗:构建高质量数据基石

- 1. 缺失值处理

- 2. 异常值检测

- 3. 数据标准化

- 三、数据探索:发现数据中的隐藏模式

- 1. 描述性统计

- 2. 相关性分析

- 3. 时间序列分析

- 四、数据建模:从数据到决策的桥梁

- 1. 用户分群(RFM模型)

- 2. 销售预测(ARIMA模型)

- 3. 推荐系统(协同过滤)

- 五、数据可视化:让数据会说话

- 1. 基础图表

- 2. 高级可视化

- 3. 交互式仪表盘

- 六、自动化与部署:让分析持续产生价值

- 1. 定时任务设置

- 2. 数据分析API化

- 3. 云服务部署

- 七、持续优化:数据分析的进化之路

在数字化转型浪潮中,数据分析已成为企业决策的核心驱动力。python凭借其丰富的生态库和简洁的语法,成为数据分析师的首选工具。本文将以实战案例为脉络,拆解数据分析全流程的关键环节,通过具体代码和场景说明如何用Python完成从数据采集到可视化呈现的完整链路。

一、数据采集:打通数据源的"任督二脉"

1. 结构化数据采集

以电商用户行为数据采集为例,可通过pandas直接读取数据库或CSV文件:

import pandas as pd

# 从CSV文件读取用户点击数据

click_data = pd.read_csv('user_clicks.csv', parse_dates=['click_time'])

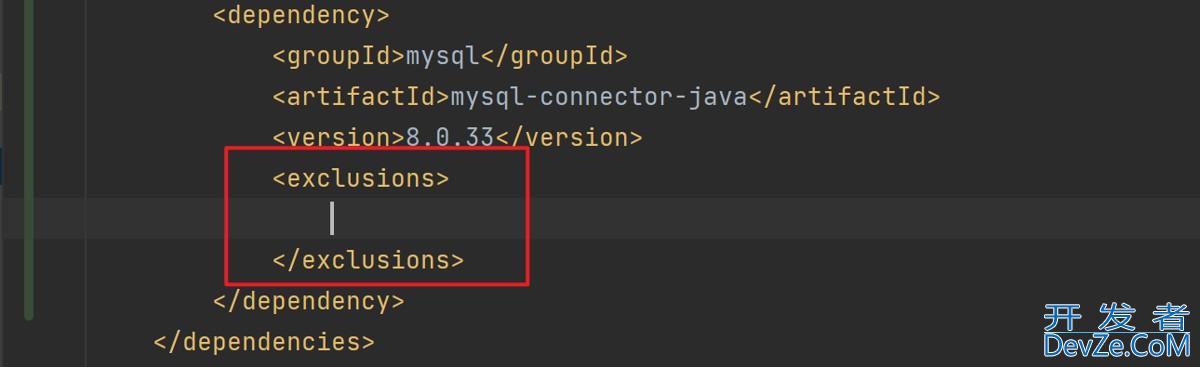

# 从mysql数据库读取订单数据

import pymysql

conn = pymysql.connect(host='localhost', user='root', password='123456', db='ecommerce')

order_data = pd.read_sql('SELECT * FROM orders WHERE order_date > "2025-01-01"', conn)

2. 网页数据爬取

针对公开网页数据,可采用requests+BeautifulSoup组合:

import requests

from bs4 import BeautifulSoup

headers = {'User-Agent': 'Mozilla/5.0'}

url = 'https://www.example.com/products'

response = requests.get(url, headers=headers)

soup = BeautifulSoup(response.text, 'html.parser')

products = []

for item in soup.select('.product-item'):

products.append({

'name': item.select_one('.name').text.strip(),

'price': float(item.select_one('.price').text[1:])

})

product_df = pd.DataFrame(products)

3. API接口调用

处理jsON格式的API数据时,requests配合字典解析更高效:

import requejssts import json api_url = 'https://www.zdaye.com' response = requests.get(api_url) sales_data = json.loads(response.text)['data'] # 转换为Python字典 sales_df = pd.DataFrame(sales_data)

实战场景:某零售企业需分析全国门店销售数据,通过混合采集方式整合:

- 历史数据:从企业数据库读取

- 实时数据:爬取竞品网站价格

- 第三方数据:调用天气API分析气候影响

二、数据清洗:构建高质量数据基石

1. 缺失值处理

以用户画像数据为例,采用业务导向的填充策略:

# 检查缺失值 print(user_data.isnull().sum()) # 年龄缺失用中位数填充(抗异常值) user_data['age'].fillna(user_data['age'].median(), inplace=True) # 地址缺失用众数填充(常见值) most_common_city = user_data['city'].mode()[0] user_data['city'].fillna(most_common_city, inplace=True)

2. 异常值检测

采用IQR方法识别订单金额异常值:

Q1 = order_data['amount'].quantile(0.25) Q3 = order_data['amount'].quantile(0.75) IQR = Q3 - Q1 lower_bound = Q1 - 1.5*IQR upper_bound = Q3 + 1.5*IQR abnormal_orders = order_data[(order_data['amount'] < lower_bound) | (order_data['amount'] > upper_bound)]

3. 数据标准化

统一日期格式和单位转换:

# 日期标准化 order_data['order_date'] = pd.to_datetime(order_data['order_date'], format='%Y-%m-%d') # 金额单位转换(元→千元) order_data['amount_k'] = order_data['amount'] / 1000

案例:某银行反欺诈系统数据清洗:

- 删除测试账户数据(标识字段含"TEST")

- 将交易时间转换为UTC时区

- 对IP地址进行地理编码转换

三、数据探索:发现数据中的隐藏模式

1. 描述性统计

快速获取数据概览:

print(sales_data.describe())

"""

amount

count 12584.000000

mean 156.320000

std 48.750000

min 12.000000

25% 125.000000

50% 150.000000

75% 175.000000

max 320.000000

"""

2. 相关性分析

识别关键影响因素:

import seaborn as sns

import matplotlib.pyplot as plt

corr_matrix = sales_data[['price', 'discount', 'amount']].corr()

sns.heatmap(corr_matrix, annot=True, cmap='coolwarm')

plt.title('销售因素相关性分析')

plt.show()

3. 时间序列分析

分解销售数据的季节性:

from statsmodels.tsa.seasonal import seasonal_decompose

result = seasonal_decompose(sales_data.set_index('date')['amount'], model='additive')

result.plot()

plt.show()

实战案例:某连锁餐饮企业分析:

- 发现周末销售额比工作日高40%

- 雨天外卖订单量增加25%

- 会员复购率是非会员的3倍

四、数据建模:从数据到决策的桥梁

1. 用户分群(RFM模型)

# 计算RFM指标

from datetime import datetime

today = datetime(2025,7,16).date()

rfm = order_data.groupby('user_id').agg({

'order_date': lambda x: (today - x.max()).days, # Recency

'user_id': 'count', # Frequency

'amount': 'sum' # Monetary

})

rfm.columns = ['R', 'F', 'M']

# 标准化处理

from sklearn.preprocessing import MinMaxScaler

scaler = MinMaxScaler()

rfm_scaled = pd.DataFrame(scaler.fit_transform(rfm), columns=rfm.columns)

# K-means聚类

from sklearn.cluster import KMeans

kmeans = KMeans(n_clusters=4, random_state=42)

rfm['cluster'] = kmeans.fit_predict(rfm_scaled)

2. 销售预测(ARIMA模型)

from statsmodels.tsa.arima.model import ARIMA

# 训练集/测试集划分

train = sales_data[:100]

test = sales_data[100:]

# 模型拟合

model = ARIMA(train['amount'], order=(1,1,1))

mjavascriptodel_fit = model.fit()

# 预测

forecast = model_fit.forecast(steps=len(test))

# 评估

from sklearn.metrics import mean_squared_error

mse = mean_squared_error(test['amount'], forecast)

print(f'预测均方误差: {mse:.2f}')

3. 推荐系统(协同过滤)

from sklearn.neighbors import NearestNeighbors # 构建用户-商品矩阵 user_item_matrix = pd.pivot_table(click_data, values='click', index='user_id', columns='product_id', aggfunc='count').fillna(0) # 训练模型 model = NearestNeighbors(n_neighbors=5, metric='cosine') model.fit(user_item_matrix) # 为用户推荐商品 user_id = 123 distances, indices = model.kneighbors([user_item_matrix.loc[user_id]]) recommended_products = user_item_matrix.columns[indices[0][1:]] # 排除自身

行业应用:

- 电商平台:个性化商品推荐提升转化率15%

- 制造业:设备故障预测减少停机时间3php0%

- 金融行业:信贷风险评估降低坏账率8%

五、数据可视化:让数据会说话

1. 基础图表

# 销售额趋势图

plt.figure(figsize=(12,6))

sales_data.set_index('date')['amount'].plot()

plt.title('日销售额趋势')

plt.ylabel('金额(千元)')

plt.grid(True)

plt.show()

# 商品类别分布

plt.figure(figsize=(8,6))

sales_data['category'].value_counts().plot(kind='barh')

plt.title('商品类别销售占ODiFjXDmp比')

plt.xlabel('销量')

plt.show()

2. 高级可视化

# 热力图展示不同时段销售情况

pivot_table = sales_data.pivot_table(index='hour', columns='weekday', values='amount', aggfunc='sum')

sns.heatmap(pivot_table, cmap='YlOrRd', annot=True, fmt='.0f')

plt.title('工作日/时段销售热力图')

plt.show()

# 地理分布图(需安装folium)

import folium

m = folium.Map(location=[35,105], zoom_start=4)

for _, row in store_data.iterrows():

folium.CircleMarker(

location=[row['lat'], row['lng']],

radius=row['sales']/1000,

color='red',

fill=True

).add_to(m)

m.save('stores_map.html')

3. 交互式仪表盘

使用Plotly创建动态图表:

import plotly.express as px

fig = px.scatter(sales_data, x='price', y='amount',

color='category', size='quantity',

hover_data=['product_name'],

title='商品价格-销量关系分析')

fig.show()

可视化设计原则:

- 选择合适的图表类型(趋势用折线图,占比用饼图)

- 保持色彩一致性(同类数据使用相同色系)

- 添加数据标签和图例说明

- 避免过度装饰(3D效果、多余背景)

六、自动化与部署:让分析持续产生价值

1. 定时任务设置

使用APScheduler实现每日报告生成:

from apscheduler.schedulers.blocking import BlockingScheduler

def generate_daily_report():

# 数据采集、分析、可视化代码

report = create_sales_report()

report.to_excel('daily_report.xlsx')

scheduler = BlockingScheduler()

scheduler.add_job(generate_daily_report, 'cron', hour=8, minute=30)

scheduler.start()

2. 数据分析API化

使用Flask创建分析接口:

from flask import Flask, request, jsonify

app = Flask(__name__)

@app.route('/analyze', methods=['POST'])

def analyze():

data = request.json

# 执行分析逻辑

result = {

'trend': calculate_trend(data),

'segments': cluster_users(data)

}

return jsonify(result)

if __name__ == '__main__':

app.run(port=5000)

3. 云服务部署

将分析应用部署到AWS Lambda:

# lambda_function.py

import pandas as pd

def lambda_handler(event, context):

# 从S3读取数据

ODiFjXDmp s3_client = boto3.client('s3')

obj = s3_client.get_object(Bucket='my-data-bucket', Key='sales.csv')

data = pd.read_csv(obj['Body'])

# 执行分析

result = analyze_data(data)

# 存储结果

s3_client.put_object(Bucket='my-result-bucket',

Key='analysis_result.json',

Body=result.to_json())

return {'statusCode': 200}

七、持续优化:数据分析的进化之路

性能优化:

- 对大数据集使用Dask替代pandas

- 用Numba加速数值计算

- 实现增量式数据处理

模型迭代:

- 建立A/B测试框架验证模型效果

- 实现自动化特征工程管道

- 采用集成方法提升预测精度

团队协作:

- 使用DVC进行数据版本控制

- 搭建MLflow模型管理平台

- 制定数据分析SOP文档

案例:某物流公司通过持续优化:

- 路径规划算法使配送效率提升22%

- 动态定价模型增加营收18%

- 自动化报告系统节省人力成本40%

- 结语:数据分析的终极价值在于行动

从数据采集到可视化呈现,Python数据分析的每个环节都蕴含着业务价值转化的机会。关键在于:

- 始终以业务问题为导向

- 保持数据质量的持续监控

- 建立分析结果的可追溯机制

- 推动数据文化在组织中的渗透

数据分析不是一次性的技术活动,而是持续改进的业务实践。当分析结果能够直接影响决策、优化流程、创造价值时,数据分析师才真正完成了从技术执行者到业务伙伴的角色转变。

到此这篇关于Python进行数据分析的全流程指南的文章就介绍到这了,更多相关Python数据分析内容请搜索编程客栈(www.devze.com)以前的文章或继续浏览下面的相关文章希望大家以后多多支持编程客栈(www.devze.com)!

加载中,请稍侯......

加载中,请稍侯......

精彩评论