Golang中多个线程和多个协程的使用区别小结

目录

- 一、本质区别:操作系统线程 vs 用户态协程

- 1. 操作系统线程(OS Thread)

- 2. Goroutine(协程)

- 二、全方位对比:线程与协程的差异

- 三、调度机制:内核调度器 vs Go调度器

- 操作系统线程调度

- Goroutine调度(GMP模型)

- 四、通信机制对比:共享内存 vs Channel

- 线程通信:共享内存+编程客栈锁

- 协程通信:Channel

- 五、错误处理差异

- 线程错误处理

- Goroutine错误处理

- 六、实战场景对比

- 场景1:Web服务器并发处理

- 场景2:批量数据处理

- 七、协程最佳实践

- 1. 控制并发度

- 2. 协程生命周期管理

- 3. 错误收集模式

- 八、线程的适用场景

- 1. CPU密集型计算

- 2. 调用阻塞系统调用

- 3. 与C/C++库深度集成

- 九、总结:选择之道的黄金法则

在Go语言中,"开多个线程"和"开多个协程"是两种截然不同的并发模型。许多开发者误以为它们是简单的1:1替代关系,实则它们在资源消耗、调度机制和性能表现上存在天壤之别。本文将彻底揭示这两者的本质差异,并通过实战数据展示为何Goroutine能支撑百万级并发。

一、本质区别:操作系统线程 vs 用户态协程

1. 操作系统线程(OS Thread)

// CGO示例:创建POSIX线程

/*

#include <pthread.h>

void* thread_func(void* arg) {

// 线程逻辑

return NULL;

}

*/

import "C"

func main() {

var thread C.pthread_t

C.pthread_create(&thread, nil, (*[0]byte)(C.thread_func), nil)

C.pthread_join(jsthread, nil)

}

核心特性:

- 内核态实现:由操作系统调度

- 固定栈大小:通常2MB(linux)

- 上下文切换:涉及内核/用户态切换(1000-1500ns)

- 资源开销:每个线程独立内存空间

- 调度成本:系统调用,触发中断

2. Goroutine(协程)

func main() {

// 启动百万协程

for i := 0; i < 1_000_000; i++ {

go func(id int) {

// 协程逻辑

time.Sleep(time.Second)

}(i)

}

time.Sleep(2 * time.Second)

}

核心特性:

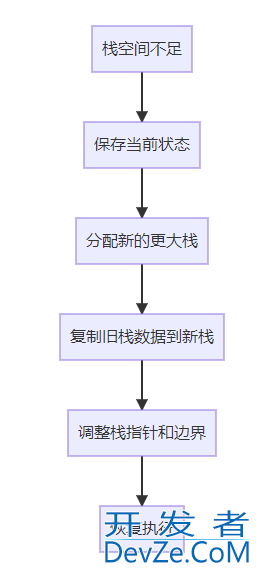

- 用户态实现:Go运行时调度

- 动态栈:初始2KB,可伸缩(最大1GB)

- 上下文切换:纯用户态(200-500ns)

- 资源开销:共享堆栈空间

- 调度机制:协作式抢占调度

二、全方位对比:线程与协程的差异

| 维度 | 操作系统线程 | Goroutine(协程) | 差异倍数 |

|---|---|---|---|

| 初始栈大小 | 2MB | 2KB | 1000倍 |

| 创建耗时 | 10-30μs | 0.1-0.3μs | 100倍 |

| 上下文切换耗时 | 1000-1500ns | 200-500ns | 3-5倍 |

| 内存占用(100万个) | 2TB | 2-4GB | 500倍 |

| 调度机制 | 内核抢占式调度 | 用户态协作式调度 | 本质不同 |

| 通信机制 | 共享内存/信号量 | Channel/Select | 范式不同 |

| 最大并发数(实际) | 数千 | 数百万 | 1000倍 |

三、调度机制:内核调度器 vs Go调度器

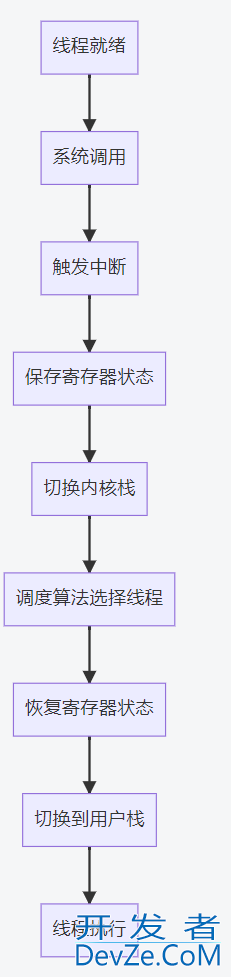

操作系统线程调度

痛点:

- 每次切换涉及30+寄存器保存

- 需要TLB刷新

- 缓存局部性破坏

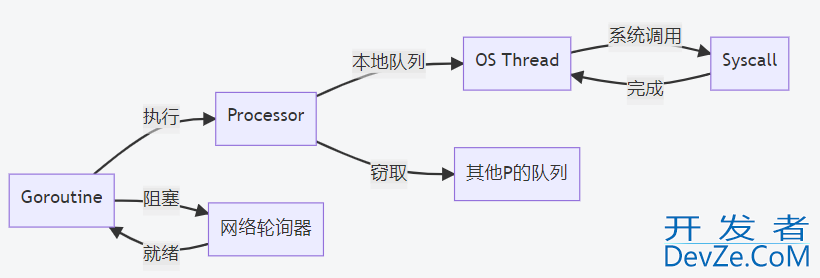

Goroutine调度(GMP模型)

优化点:

- 工作窃取(Work Stealing):平衡负载

- 网络轮询器:I/O阻塞不占用线程

- 协作式抢占:函数调用时检查抢占

- 本地队列:无锁访问

四、通信机制对比:共享内存 vs Channel

线程通信:共享内存编程+锁

var counter int

var mu sync.Mutex

func threadFunc() {

mu.Lock()

counter++ // 临界区操作

mu.Unlock()

}

风险:

- 死锁风险

- 竞态条件

- 缓存一致性问题

协程通信:Channel

ch := make(chan int, 10)

// 生产者

go func() {

for i := 0; i < 100; i++ {

ch <- i // 发送数据

}

close(ch)

}()

// 消费者

go func() {

for n := range ch {

fmt.Println(n) // 接收数据

}

}()

优势:

- CSP模型:Communicating Sequential Processes

- 无共享内存:避免竞态条件

- 阻塞语义:自动同步

- Select多路复用:简化复杂逻辑

五、错误处理差异

线程错误处理

// C线程示例

void* thread_func(void* arg) {

if (error) {

return (void*)-1; // 错误传递困难

}

return NULL;

}

限制:

- 错误无法跨线程传播

- 缺乏统一错误处理机制

- 资源清理复杂

Goroutine错误处理

func worker(errCh chan error) {

defer func() {

if r := recover(); r != nil {

errCh <- fmt.Errorf("panic: %v", r)

}

}()

if err := doWork(); err != nil {

errCh <- err

}

}

func main() {

errCh := make(chan error, 10)

go worker(errCh)

select {

case err := <-errCh:

log.Fatal("Worker failed:", err)

}

}

优势:

- 错误通道统一收集

- defer+recover安全机制

- 上下文传递取消信号

六、实战场景对比

场景1:Web服务器并发处理

线程方案(C++/Java):

// Java线程池

ExecutorService pool = Executors.newFixedThreadPool(200);

for (Request req : requests) {

pool.submit(() -> {

processRequest(req); // 最大并发200

});

}

协程方案(Go):

func handleRequest(w http.ResponseWriter, r *http.Request) {

// 每个请求独立协程

go process(r)

}

func main() {

http.HandleFunc("/", handleRequest)

http.ListenAndServe(":8080", nil) // 轻松支持10万并发

}

性能对比:

- QPS:线程池(5k) vs 协程(50k+)

- 内存占用:线程池(400MB) vs 协程(50MB)

场景2:批量数据处理

线程方案:

# python线程

threads = []

for data in big_dataset:

t = threading.Thread(target=process, args=(data,))

t.start()

threads.append(t)

for t in threads:

t.join() # 创建数千线程即崩溃

协程方案:

// Go协程+工作池

func worker(da编程taCh chan Data, wg *sync.WaitGroup) {

defer wg.Done()

for data := range dataCh {

process(data)

}

}

func main() {

dataCh := make(chan Data, 1000)

var wg sync.WaitGroup

// 启动100个工作者协程

for i := 0; i < 100; i++ {

wg.Add(1)

go worker(dataCh, &wg)

}

// 发送数据

for _, data := range bigDataset {

dataCh <- data

}

close(dataCh)

wg.Wait()

}

优势:

- 控制并发度

- 避免资源耗尽

- 自动负载均衡

七、协程最佳实践

1. 控制并发度

// 使用信号量控制

sem := make(chan struct{}, 1000) // 最大1000并发

for _, task := range tasks {

sem <- struct{}{} // 获取信号

go func(t Task) {

defer func() { <-sem }() // 释放信号

process(t)

}(task)

}

2. 协程生命周期管理

func runService(ctx context.Context) {

for {

select {

case <-ctx.Done(): // 监听取消

cleanup()

return

case data := <-inputCh:

process(data)

}

}

}

func main() {

ctx, cancel := context.WithCancel(context.Background())

go runService(ctx)

// 需要停止时

cancel() // 安全停止协程

}

3. 错误收集模式

func worker(id int, errCh chan error) {

if err := doWork(); err != nil {

errCh <- fmt.Errorf("worker %d: %w", id, err)

}

}

func main() {

errCh := make(chan error, 10)

for i := 0; i < 10; i++ {

go worker(i, errCh)

}

// 收集错误

for i := 0; i < 10; i++ {

if err := <-errCh; err != nil {

log.Println("Error:", err)

}

}

}

八、线程的适用场景

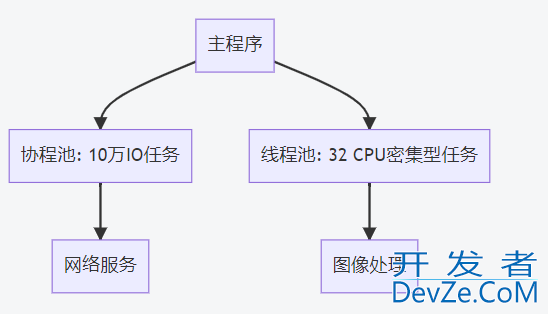

尽管协程优势明显,线程仍有其不可替代的场景:

1. CPU密集型计算

// CGO调用原生线程

/*

#include <math.h>

void heavyCompute() {

// 密集计算

for (int i=0; i<1000000; i++) {

sqrt(i);

}

}

*/

import "C"

func main() {

// 使用真实线程避免调度延迟

C.heavyCompute()

}

2. 调用阻塞系统调用

// 绕过Go调度器

func rawSyscall() {

// 直接系统调用

_, _, errno := syscall.Syscall(

syscall.SYS_GETPID,

0, 0, 0,

)

// ...

}

3. 与C/C++库深度集成

// 创建专用线程

/*

static void* thread_entry(void* arg) {

// 长期运行的C线程

return NULL;

}

*/

import "C"

func main() {

var t C.pthread_t

C.pthread_create(&t, nil, C.thread_entry, nil)

}

九、总结:选择之道的黄金法则

默认选择协程:

- 99%的并发场景使用Goroutine

- 享受轻量级、高并发优势

线程使用场景:

- CPU密集型计算

- 与系统API深度交互

- 集成C/C++线程库

混合架构:

线程是重型卡车,适合拉重货;协程是集装箱船队,适合大规模运输。在Go的并发世界里,学会组建你的’集装箱船队javascript’,才能高效处理数字时代的并发洪流。

无论你选择哪种并发模型,理解其底层机制和适用场景,才是构建高性能、可扩展系统的关键。在Go的生态中,Goroutine已经证明:通过精心设计的用户态调度,我们完全能实现’小而美’的百万级并发。

到此这篇关于golang中多个线程和多个协程的使用区别小结的文章就介绍到这了,更多相关Golang 多线程和多协程内容请搜索编程客栈(www.devze.com)以前的文章或继续浏览下面的相关文章希望大家以后多多支持编程客栈(www.devze.com)!

加载中,请稍侯......

加载中,请稍侯......

精彩评论