PyTorch中F.softmax的具体使用

目录

- Softmax 函数的定义

- F.softmax 的作用

- 用法

- 详细解释

- 示例代码解释

- 为什么使用 Softmax?

- Softmax 与 Logits

- 示例:多分类任务中的 Softmax

- 总结

F.softmax 是 PyTorch 中用于计算 Softmax 函数 的函数,通常用于 多分类任务 的输出层,用来将模型的原始输出(称为 logits)转化为概率分布。

Softmax 函数将每个类别的得分(logits)转换为一个介于 0 和 1 之间的概率值,并且所有类别的概率之和等于 1。

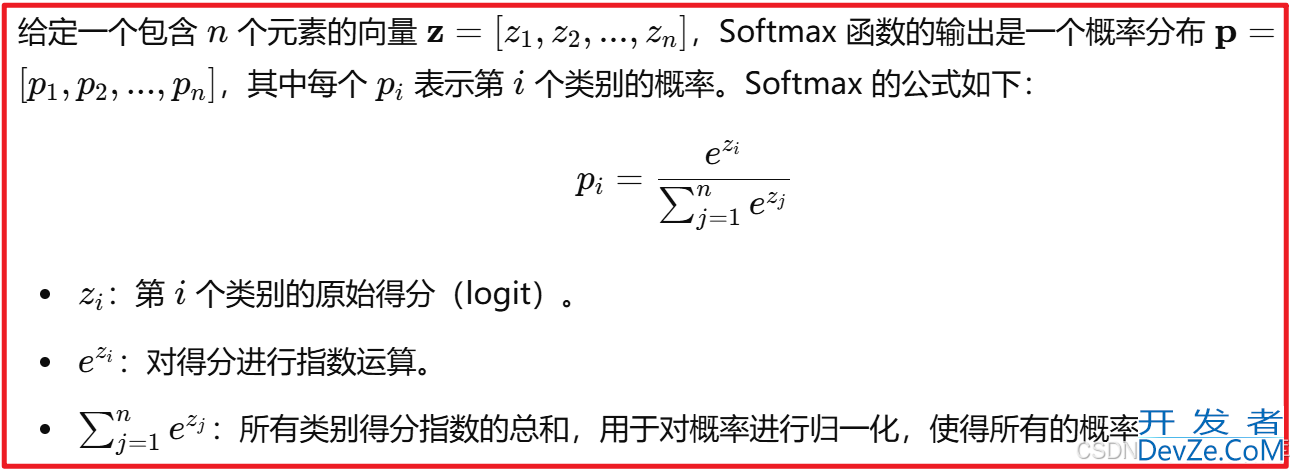

Softmax 函数的定义

给定一个包含

:第

个类别的原始得分(logit)。

:对得分进行指数运算。

-

:所有类别得分指数的总和,用于对概率进行归一化,使得所有的概率和为 1。

F.softmax 的作用

F.softmax 函数将给定的 logits(即模型的原始输出)转换为概率分布。

假设我们有一个包含 10 个类别的模型输出,那么 F.softmax 会将这 10 个 logits 转化为 10 个概率,每个概率值在 0 到 1 之间,并且所有 10 个概率的和为 1。

用法

在 PyTorch 中,F.softmax 由 torch.nn.functional 模块提供,使用方式如下:

import torch import torch.nn.functional as F # 假设我们有一个大小为 [BATch_size, num_classes] 的张量 logits = torch.tensor([[1.0, 2.0, 3.0], [1.0, 2.0, 3.0]]) # 计算 softmax,dim=1 表示对每一行进行 softmax 计算 probabilities = F.softmax(logits, dim=1) print(probab编程客栈ilities)

详细解释

logits:是一个 2D 张量,每一行表示一个样本的原始输出值(logits),每一列表示该样本在某个类别的得分。

dim=1:指定了计算 Softmax 的维度。

dim=1表示对每一行计算 Softmax,即每个样本的得分都会被转化为一个概率分布。注意,如果是处理多维数据,可以通过调整dim来指定 Softmax 计算的维度。- 如果

dim=0,则对每列计算 Softmax,通常在处理多批次数据时不常用。

- 如果

output:Softm编程客栈ax 转换后的输出是一个概率分布,所有元素都在 0 到 1 之间,并且每行的元素和为 1。

示例代码解释

import torch import torch.nn.functional as F # 假设输入是一个大小为 (2, 3) 的张量,其中 2 是 batch_size,3 是类别数 logits = torch.tensor([[1.0, 2.0, 3.0], [1.0, 2.0, 3.0]]) # 计算 Softmax,按照列来计算,即对每行进行 Softmax probabilities = F.softmax(logits, dim=1) print(probabilities)

输入:

tensor([[1.0, 2.0, 3.0],

[1.0, 2.0, 3.0]])

输出:

tensor([[0.09003057, 0.24472847, 0.66524096],

[0.09003057, 0.24472847, 0.66524096]])

解释:

- 对于每一行的得分,Softmax 会将其转换为概率。

- 第一行

[1.0, 2.0, 3.0]经过 Softmax 处理后得到[0.0900, 0.2447, 0.6652],这些概率值的总和为 1。 - 第二行

[1.0, 2.0, 3.0]同样编程经过 Softmax 转换后,得到相同的概率分布[0.0900, 0.2447, 0.6652],这也保证了概率总和为 1。

- 第一行

为什么使用 Softmax?

多分类任务:在多分类问题中,模型的输出通常是每个类别的原始得分。Softmax 函数能够将这些得分转化为概率分布,使得每个类别的预测概率能够加起来为 1,并且通过最大概率来做预测。

分类概率:Softmax 给出的每个类别的概率可以帮助我们了解模型对每个类别的信心程度。对于实际应用,通常选择概率最大的类别作为模型的预测结果。

Softmax 与 Logits

- Logits 是未经处理的原始输出值,通常来自神经网络的输出层。

- Softmax 是对 logits 的一种规范化,它将 logits 转换为 0 到 1 之间的概率值。

示例:多分类任务中的 Softmax

假设我们有一个多分类任务,模型的输出是一个包含 4 个类别的 logits 向量,[2.0, 1.0, 0.1, 0.5]。

我们希望将其转换为类别的概率分布。

import torch import torch.nn.functional as F logits = torch.tensor([2.0, 1.0, 0.1, 0.5]) # 使用 F.softmax 将 logits 转换为概率分布 probabilities = F.softmax(logits, dim=0) print(probabilities)

输出:

tensor([0.5438, 0.1993, 0.0717, 0.1852])

解释:

- 原始 logits 为

[2.0, 1.0, 0.1, 0.5],经过 Softmax 处理后,得到了每个类php别的概率[0.5438, 0.1993, 0.0717, 0.1852]。概率最大的类别是第一个类别,其概率为 0.5438。

总结

- Softmax 函数将 logisThuhKts 转换为概率分布,适用于多分类任务。

- 它保证了输出的每个类别概率值在 0 到 1 之间,并且所有概率的和为 1。

- 在 PyTorch 中,

F.softmax是计算 Softmax 的常用函数,通常与CrossEntropyLoss搭配使用。

到此这篇关于PyTorch中F.softmax的具体使用的文章就介绍到这了,更多相关PyTorch F.softmax内容请搜索编程客栈(www.devze.com)以前的文章或继续浏览下面的相关文章希望大家以后多多支持编程客栈(www.devze.com)!

加载中,请稍侯......

加载中,请稍侯......

精彩评论