PostgreSQL容器磁盘I/O监控与优化指南

目录

- 容器环境下的 I/O 监控挑战

- BusyBox 的限制

- 容器与宿主机 I/O 隔离

- 基础监控方案实施

- 使用 BusyBox 版 IOStat

- 指标阈值参考

- 高级监控方案部署

- 方案 1:安装完整 sysstat 工具集

- 方案 2:宿主机级监控

- PostgreSQL 专项 I/O 分析

- WAL 写入模式识别

- 数据文件访问模式

- 性能优化实战策略

- 配置调优建议

- 查询android优化技巧

- 存储架构建议

- 异常情况处理流程

- 高 I/O 问题诊断步骤

- 应急措施

- 长期监控体系建设

- Prometheus+Grafana 方案

- 关键仪表盘指标

- 容器特定优化技巧

- docker 存储驱动选择

- 挂载选项优化

- 资源限制策略

容器环境下的 I/O 监控挑战

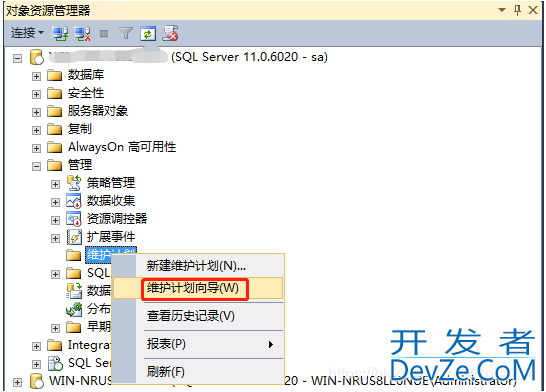

BusyBox 的限制

许多轻量级 PostgreSQL 容器镜像(如官方镜像)基于 BusyBox 构建,其提供的工具链为精简版本。标准 linux 发行版中的iostat命令支持丰富的参数选项,而 BusyBox 版本则功能有限:

iostat -d -k 2 # BusyBox可用基础命令 iostat -dx 2 # 完整版功能,BusyBox不支持

这种限制使得我们需要采用替代方案获取必要的性能数据。

容器与宿主机 I/O 隔离

Docker 容器虽然共享宿主机的内核,但通www.devze.com过 cgroups 实现资源隔离。这意味着:

- 容器内看到的磁盘设备可能是虚拟化的

- 直接使用宿主机的监控工具可能无法准确反映容器真实的 I/O 状况

- 需要特殊方法关联容器进程与物理设备

基础监控方案实施

使用 BusyBox 版 iostat

在标准 PostgreSQL 容器中执行:

docker exec -it test-postgresql bash -c "iostat -d -k 2"

典型输出示例:

Device tps kB_read/s kB_wrtn/s kB_dscd/s kB_read kB_wrtn kB_dscd vda 5.67 32.45 128.76 0.00 1048576 4194304 0

关键指标解析:

- tps:每秒 I/O 请求次数,反映磁盘负载压力

- kB_read/s:读取吞吐量,影响查询性能

- kB_wrtn/s:写入吞吐量,关系事务提交速度

- kB_dscd/s:通常为 0,除非使用 discard/TRIM 功能

指标阈值参考

| 指标 | 机械硬盘警戒值 | SSD 警戒值 | 可能问题 |

|---|---|---|---|

| tps | >500 | >2000 | I/O 队列堆积 |

| kB_read/s | >50MB | >200MB | 全表扫描频繁 |

| kB_wrtn/s | >30MB | >100MB | WAL 写入压力大 |

高级监控方案部署

方案 1:安装完整 sysstat 工具集

对于长期运行的生产环境容器,建议安装完整监控工具:

# Debian/Ubuntu系容器 docker exec -it test-postgresql bash -c "apt update && apt install -y sysstat" # Alpine系容器 docker exec -it test-postgresql bash -c "apk add sysstat"

安装后可使用增强功能:

iostat -dx 2 # 显示扩展统计 iostat -c 2 # 查看CPU与I/O等待关系

方案 2:宿主机级监控

通过宿主机监控具体设备:

# 查找容器使用的实际设备 device=$(docker inspect test-postgresql | grep -A5 "DeviceName" | grep "Source" | cut -d'"' -f4) # 监控该设备 iostat -dx $device 2

优势:

- 绕过容器限制

- 获取更底层性能数据

- 可与其它系统进程关联分析

PostgreSQL 专项 I/O 分析

WAL 写入模式识别

PostgreSQL 的预写日志(WAL)会产生特定 I/O 模式:

- 持续的小量写入(每个事务)

- 周期性的批量写入(检查点)

通过 iostat 观察:

kB_wrtn/s呈现规律性波动 → 检查点活动 持续高kB_wrtn/s → 事务量过大

数据文件访问模式

表与索引的不同访问方式会产生不同 I/O 特征:

- 随机读取(索引查询)

- 顺序读android取(全表扫描)

- 批量写入(COPY 或 INSERT…SELECT)

性能优化实战策略

配置调优建议

- WAL 优化

ALTER SYSTEM SET wal_buffers = '16MB'; -- 默认4MB,大事务可增加 ALTER SYSTEM SET checkpoint_completion_target = 0.9; -- 平滑检查点 ALTER SYSTEM SET max_wal_size = '2GB'; -- 根据负载调整

- 内存配置

ALTER SYSTEM SET shared_buffers = '4GB'; -- 通常设为内存25% ALTER SYSTEM SET ehttp://www.devze.comffective_cache_size = '12GB'; -- 可用内存的50-75%

- I/O 成本参数

-- 对于SSD存储 ALTER SYSTEM SET random_page_cost = 1.1; ALTER SYSTEM SET seq_page_cost = 1.0;

查询优化技巧

- 识别高 I/O 查询:

SELECT query, calls, total_time, shared_blks_read FROM pg_stat_statements ORDER BY shared_blks_read DESC LIMIT 10;

添加适当索引减少全表扫描

对大表考虑分区策略

存储架构建议

- 设备选型

- OLTP 负载:高性能 SSD(如 NVMe)

- 分析型负载:高吞吐量 SSD 或 RAID 阵列

- 目录规划

/var/lib/postgresql/data → 主数据(高性能设备) /pg_wal → 单独高速设备(可选) /pg_log → 可放在普通设备

- 文件系统选择

- XFS:通常表现最佳

- ext4:稳定通用选择

- 挂载选项:

noatime,nodiratime,data=writeback

异常情况处理流程

高 I/O 问题诊断步骤

- 确认 I/O 瓶颈确实存在

- 区分读密集还是写密集

- 关联 PostgreSQL 活动会话

- 检查检查点与 WAL 状态

- 分析慢查询与执行计划

应急措施

- 临时增加检查点间隔:

ALTER SYSTEM SET checkpoint_timeout = '30min'; SELECT pg_reload_conf();

- 限制并发连接数:

ALTER SYSTEM SET max_connections = 100;

- 启用工作内存调整:

ALTER SYSTEM SET work_mem = '8MB';

长期监控体系建设

Prometheus+Grafana 方案

部署容器化监控栈:

# docker-compose-monitoring.yml

version: "3"

services:

prometheus:

image: prom/prometheus

ports: ["9090:9090"]

grafana:

image: grafana/grafana

ports: ["3000:3000"]

node-exporter:

image: prom/node-exporter

volumes: ["/proc:/host/proc", "/sys:/host/sys"]

配置 PostgreSQL exporter 采集 I/O 相关指标

关键仪表盘指标

- 磁盘利用率面板

- I/O 等待时间趋势

- WAL 生成速率

- 缓冲区命中率

- 检查点间隔统计

容器特定优化技巧

Docker 存储驱动选择

推荐配置:

{

"storage-driver": "overlay2",

"storage-opts": ["overlay2.override_kernel_check=true"]

}

挂载选项优化

docker run -d \ --mount type=volume,dst=/var/lib/postgresql/data,volume-opt=type=xfs \ postgres:14

资源限制策略

docker run -d \ --memory="8g" \ --memory-swap="12g" \ --cpu-shares=1python024 \ --blkio-weight=500 \ postgres:14

以上就是PostgreSQL容器磁盘I/O监控与优化指南的详细内容,更多关于PostgreSQL I/O监控与优化的资料请关注编程客栈(www.devze.com)其它相关文章!

加载中,请稍侯......

加载中,请稍侯......

精彩评论